Kaum ein großes Online-Medium jenseits des Qualitätsjournalismus kommt ohne Horoskop aus. Und das, obwohl schon Adorno der Astrologie vor mehr als 50 Jahren bescheinigte, dass die sozialen und psychologischen Bedingungen, die sie ermöglichten, mit dem (damaligen) allgemeinen Aufklärungszustand unvereinbar seien.

Astrologie zwischen Rationalität und Irrationalität

Aus Sicht der Astrologie wirken Gestirnkonstellationen unmittelbar auf den irdischen Gang der Dinge. Sie vermittelt damit ein Weltbild, in dem jeder Mensch unter dem Einfluss objektiver, abstrakter und depersonalisierter Kräfte handelt. So objektiv mess- und berechenbar der Lauf der Gestirne auch sein mag, über die Art und Weise ihres (vermeintlichen) Einflusses auf die Schicksale der Menschen lässt die Astrologie uns im Dunkeln. Dieses Nebeneinander von Rationalität, Empirismus und Transzendenz hat Adorno im Oxymoron des naturalistischen Supranaturalismus gefasst. Folgt man Adorno, korrespondiert dieses Weltbild der Wahrnehmung vieler Menschen in funktional hochgradig differenzierten Gesellschaften: die Unübersichtlichkeit der Welt und die Sinnlosigkeit und Berdohlichkeit sozialer Prozesse wird durch den Glauben an eine Instanz kompensiert, die ein Versprechen auf rationale Begründbarkeit des ansonsten Unerklärlichen gibt. Auf diese Weise wirkt die Astrologie in doppelter Hinsicht stabilisierend auf die Gesellschaft, indem sie den herrschenden Rationalitätstyp bestätigt und die Irrationalitäten der sozialen Ordnung erklärbar macht.

Das Horoskop ist ein Text. Dieser Text leitet bestimmte Aspekte des Lebens einer Personengruppe, die über den Zeitpunkt ihrer Geburt definiert ist, aus einer aktuellen Gestirnkonstellation kausal ab; das klingt dann etwa so: „Unter dem aktuellen Jupiter-Uranus-Einfluss wird Ihr scharfer Zwillinge-Geist noch einmal geschärft.“ Je ausführlicher ein Horoskop ist, desto gründlicher wird die Gestirnkonstellation als argumentative Ressource genutzt. In den knappen Pressehoroskopen fällt sie dagegen sogar häufig zugunsten deutungsoffener und deshalb für jeden mit individuellem Sinn füllbarer Aussagen weg.

Sprachliche Analysen wie die von Katja Furthmann haben an Pressehoroskopen eine Reihe von Themen (Liebe, Beruf, Freizeit und Freundschaft, Gesundheit, Finanzen) und wiederkehrenden Topoi, die sich um den Metatopos des erfüllten, ausgeglichenen Lebens gruppieren („Sie haben hohe Ansprüche – gut so. Aber bitte verlangen Sie nichts Unmögliches“, „So schön die Sommerpartys auch sind, Sie sollten mal wieder richtig ausschlafen“), herausgearbeitet.

Reverse Engineering des Transzendenten mittels maschineller Textanalyse?

Wenn Horoskoptexte Übersetzungen von Gestirnkonstellationen in für den Einzelnen anschlussfähige Darstellungen künftigen Erlebens sind, dann müsste in der Analyse sprachlicher Muster von Horoskoptexten und ihrer Distribution die höhere Ordnung, die den Gang unserer aller Leben bestimmt, zumindest aufscheinen — so dachte ich. Vielleicht wäre es sogar möglich wie bei einem Reverse Engineering die Strukturen und Verhaltensweisen der Konstruktionselemente unserer Welt zu extrahieren. Ich machte mich also daran, Horoskope zu sammeln.

Das Sammeln der Horoskope gestaltete sich jedoch schwieriger als gedacht. Denn obwohl jedes größere Online-Medium täglich ein Horoskop veröffentlicht, werden die Horoskoptexte nicht archiviert. Meist ist nur das tagesaktuelle Horoskop verfügbar, selten noch das vom Tag vorher und die Horoskope weiterer Tage. Und fast immer stammen die Horoskope aus derselben Quelle, die mit lizensierten Astrologen, Content nach Maß und flexiblen Push- bzw. Pullservices wirbt.

Endlich wurde ich aber in den Tiefen und Oberflächen des Netzes fündig und konnte gemeinsam mit einem Kollegen für den Zweck der Erforschung von Textmustern 383 Tageshoroskope für jedes der zwölf Sternzeichen extrahieren. Eine simple datengeleitete Analyse gängiger Phrasen zeigte schon, dass die insgesamt 4596 Texte hochgradig rekurrent sind. Das ganze Ausmaß der Text-Re-use wurde mir aber erst deutlich, als ich die längste Überschneidung zwischen zwei Texten (longest common substring) berechnete. Mehrere Horoskoptexte waren völlig deckungsgleich. Und nicht nur das.

Im Himmel nichts Neues

Die 4596 Tageshoroskope wurden mit gerade einmal 894 unterschiedlichen Texten bestückt. Von diesen wurden 568 Texte, das sind 65.5%, mehrfach benutzt. 146 von ihnen sogar zehn mal und mehr. Der am häufigsten gebrauchte Text fand 88 mal Verwendung! Der Text besteht aus zwei Sätzen, die den Angehörigen der Zielgruppe am betreffenden Tag eine außerordentliche Selbstreflexion hinsichtlich ihrer Emotionen und Ziele voraussagt und ihnen auch einen erfüllten Kontakt mit ihren Mitmenschen prophezeit:

Sie sind sich Ihrer Gefühle, Wünsche und Bedürfnisse auf ungewöhnlich klare Weise bewusst und können entsprechend für Ihr Wohlbefinden sorgen. Auch für die Anliegen anderer sind Sie offen und begegnen ihnen mit einer menschlichen und warmen Herzlichkeit.

Positive Emotionen und herzliche Kontaktfreude sind durchweg die Themen der am häufigsten verwendeten Tageshoroskope, auch bei dem mit 72 mal am vierthäufigsten verwendeten Text:

Mehr als üblich sprechen Sie über Ihre Gefühle. Durch das Gespräch finden Sie leicht Kontakt und zeigen vermutlich auch Interesse für das Seelenleben anderer. Sie formulieren Ihre Gedanken nicht besonders sachlich und logisch, dafür umso menschlicher.

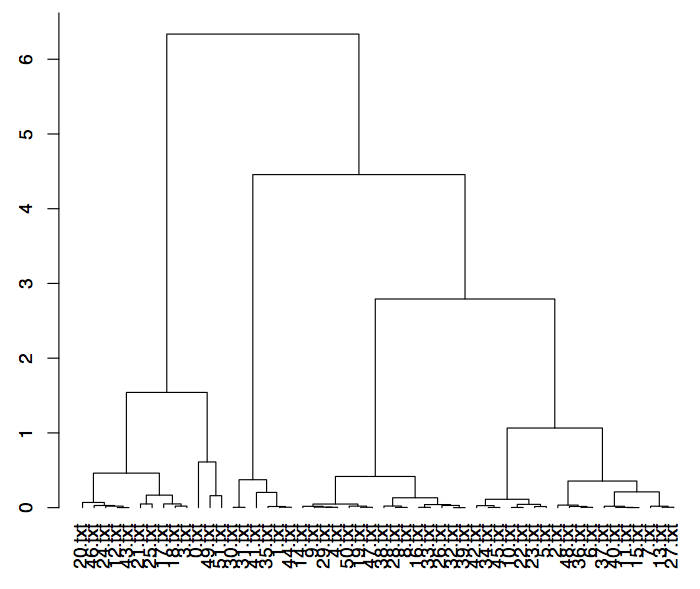

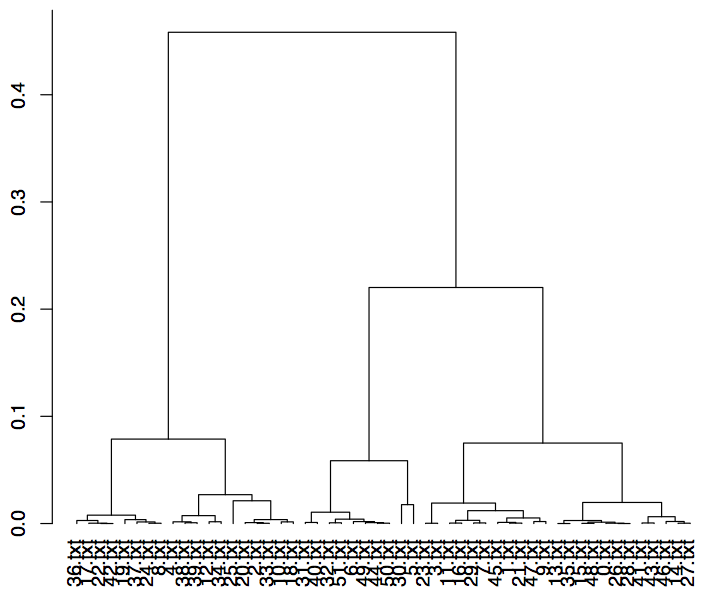

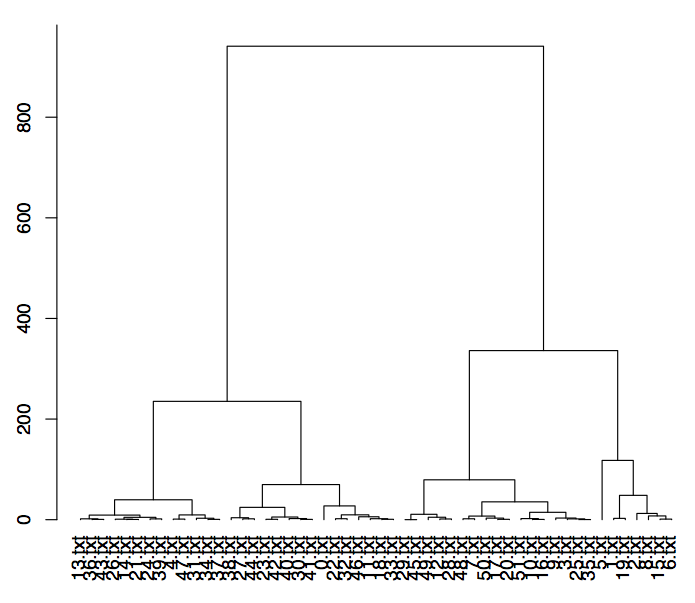

Der Traum vom Reverse-Engineering platzte endgültig, als ich die Distribution der Text über die Zeit und die Sternzeichen analysierte. Beim häufigsten Horoskoptext lässt diese Verteilung auf den ersten (und auch nicht auf den zweiten) Blick keine Muster erkennen.

Der Text streut unsystematisch über alle Sternzeichen und den gesamten Zeitraum. Einzige Restriktion: Der Text kann am selben Tag nicht bei zwei Sternzeichen gleichzeitig erscheinen. Dagegen ist es aber durchaus möglich, dass er beim gleichen Sternzeichen an zwei aufeinanderfolgenden Tagen erscheint, ja sogar an drei, wie das Beispiel des dritthäufigsten Textes belegt:

Die Analysen über das gesamte Sample zeigten keine nennenswerte Kovariation, der tiefere Sinn der Textwahl blieb ihnen ebenso verborgen wie die für den Uneingeweihten unsichtbaren Kräfte, die unsere Schicksale steuern.

Mein heutiges Horoskop lautet: „Sag es mit einem Lächeln! heißt Ihr Tagesmotto.“ Ich sei heute mitteilsam und kompromissbereit. Meine freundliche, friedfertige Stimmung werde mit mit vielen Menschen in Kontakt bringen und könne zwischen unterschiedlichen Meinungen vermitteln und eine gemeinsame Basis schaffen. Ein guter Tag, um endlich mal wieder zu bloggen, denke ich mir. Und mein heutiger Horoskoptext kommt in meinem Korpus sogar nur neun mal vor! Das ist gemessen an der sonstigen Wiederverwertungsorgie nachgerade ein individueller Text und wird ganz sicher stimmen. Wie alle Horoskope.

Literatur

Adorno, Theodor: Aberglaube aus zweiter Hand. In: Gesammelte Schriften. Band 8. Frankfurt am Main: Suhrkamp 1997, S. 142-167.

Aphek, Edna, Yishai Tobin: The Semiotics of Fortune Telling. Amsterdam u.a.: Benjamins 1989.

Furthmann, Katja: Die Sterne Lügen nicht. Eine linguistische Analyse der Textsorte Pressehoroskop. Göttingen: V&R unipress 2006.