Liebe Freunde der Sicherheit,

semantisch bestimmte Wort- und Phrasenklassen lassen sich natürlich nicht nur zur Aufdeckung subversiver Tätigkeiten benutzen, sondern auch für ganz unnütze Dinge, etwa zur Analyse von Online-Medien. Im vorletzten Posting habe ich mir die Ressortentwicklung bei SPIEGEL-Online angeschaut und herausgefunden, was wir ohnehin schon alle wussten: das von uns so geliebte Ressort „Panorama“ wurde in den letzten 10 Jahren langsam aber stetig ausgebaut, so dass es inzwischen sogar mehr Artikel umfasst als Politik-Inland oder Politik-Ausland.

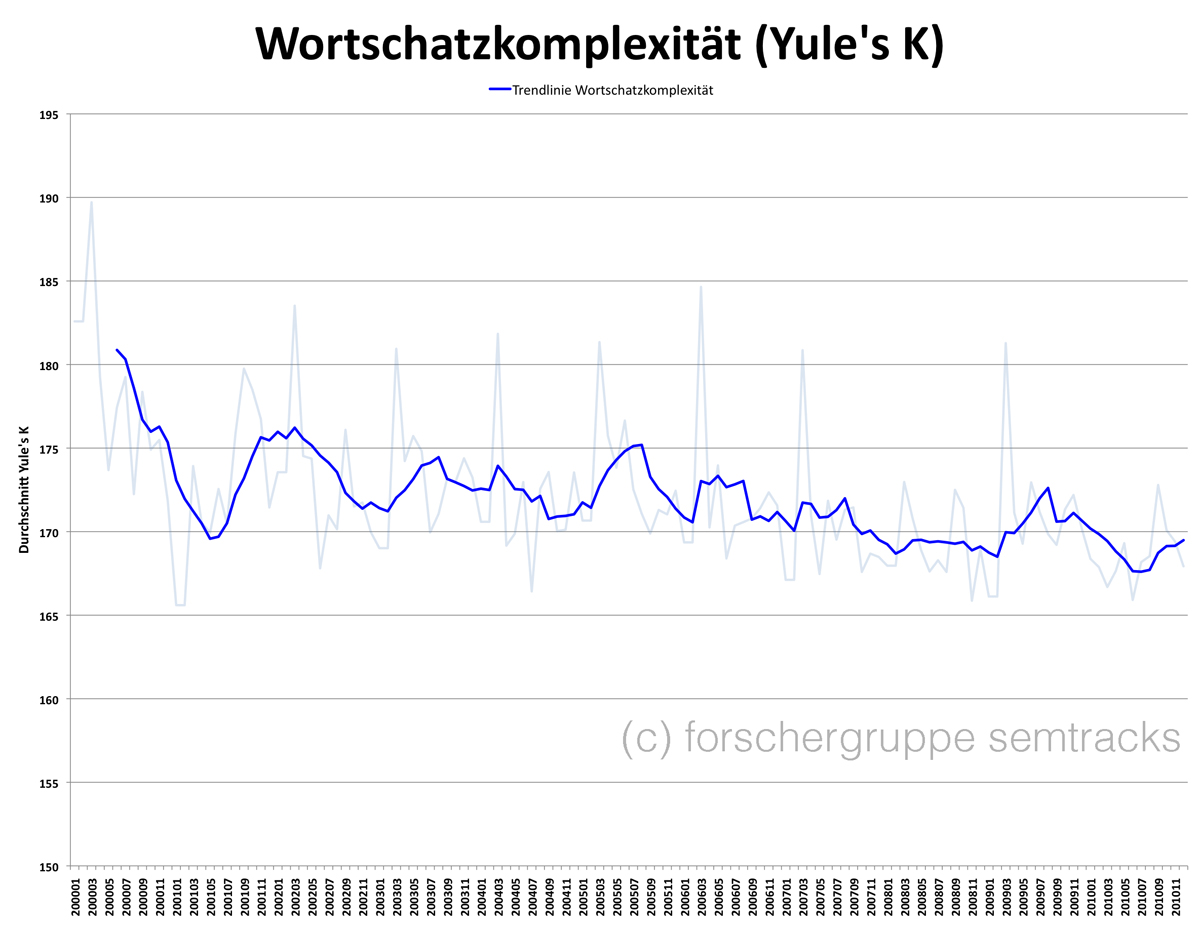

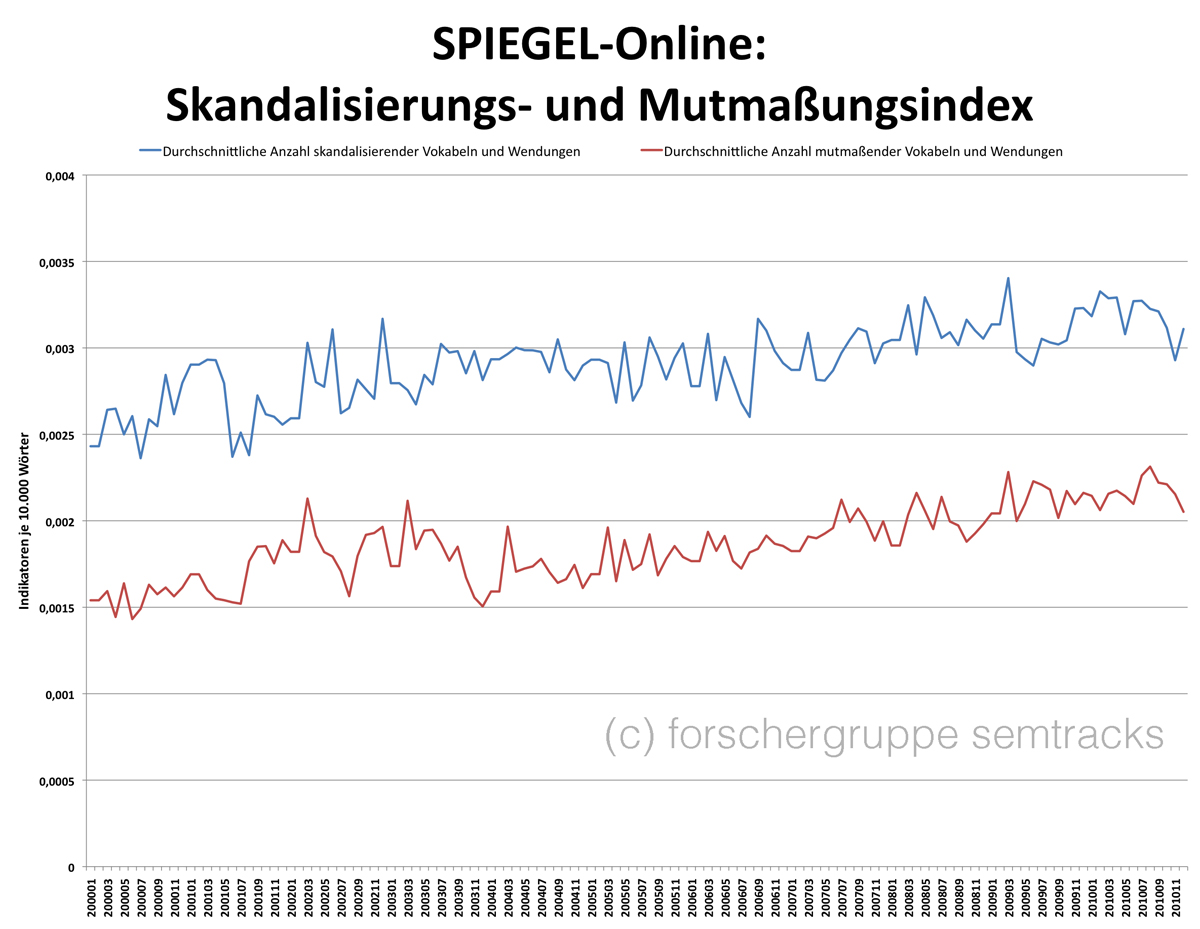

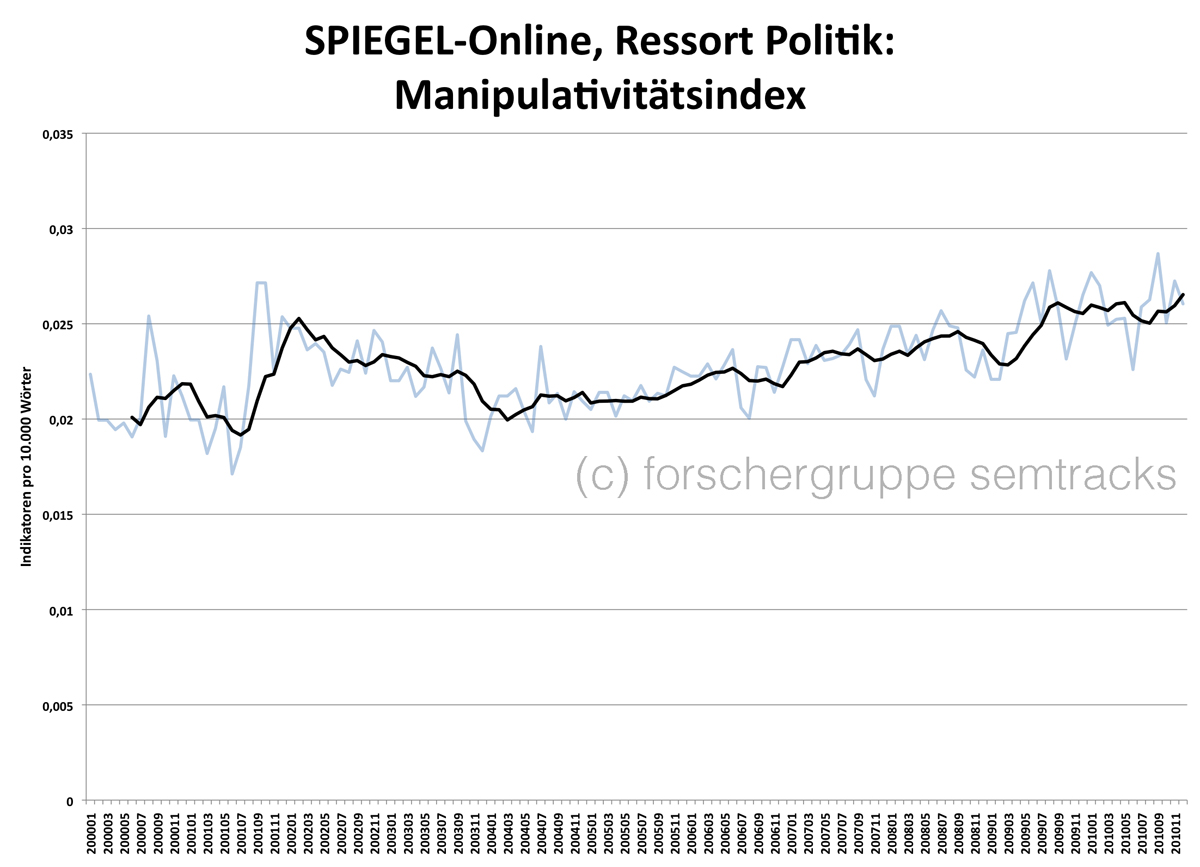

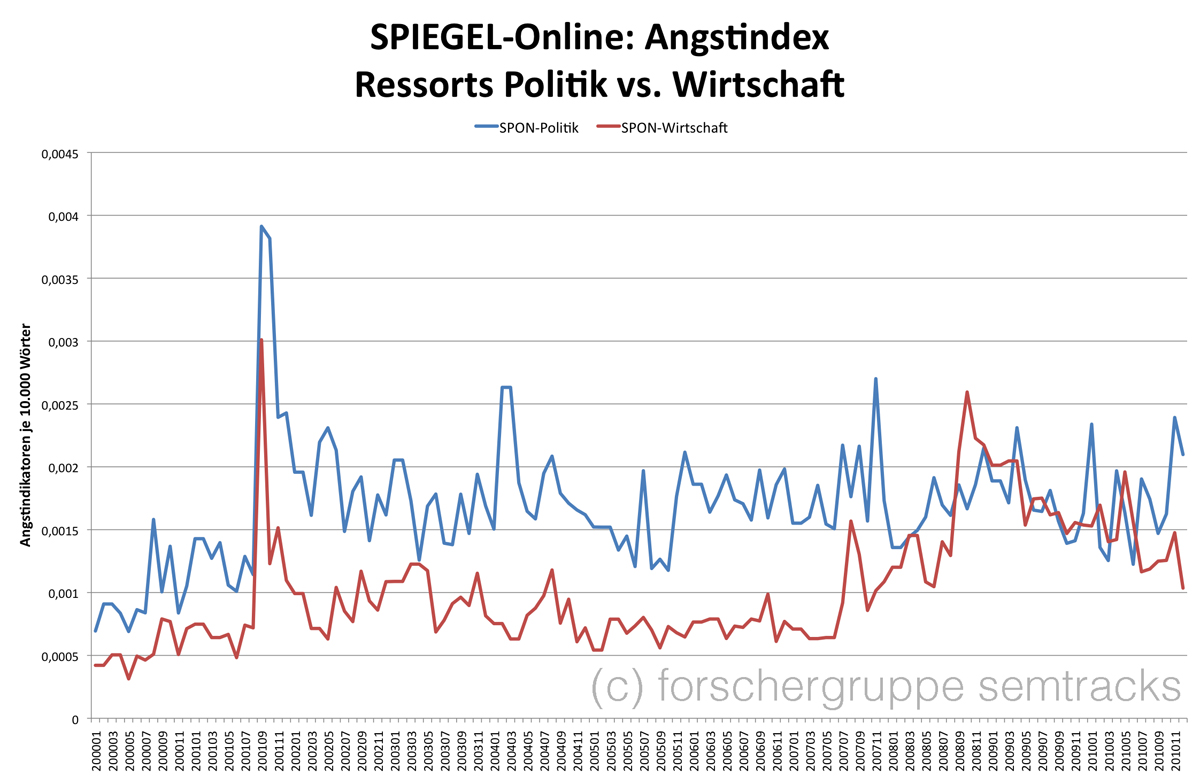

Heute möchte ich euch ein paar Zeitreihen zeigen, die man getrost als Indikator für journalistische Qualität ansehen kann. Die Zeitreihen wurden mit vergleichsweise einfachen Mitteln berechnet: Der Angstindex (man könnte ihn auch Fnordbarometer) zeigt die Anzahl von Wörtern und Wendungen an, die auf einschüchternde Sachverhalte hinweisen (Terror, Seuchen, Umweltkatastophen, Islamisten, Wirtschaftskrisen etc.). Wortschatzkomplexität habe ich mit dem Maß Yule’s K operationalisiert. Der Manipulativitätsindex setzt sich zusammen aus der Anzahl aus Wörtern und Phrasen, die auf Vermutungen bzw. unsicheres Wissen hinweisen (auch Mutmaßungsindex), der Anzahl metasprachlich markierter Wendungen (z.B. sogenannte freie Wahlen) und einer Reihe von Emotionalitätsindikatoren. Der Skandalisierungsindex beruht auf einer Taxonomie, die Lemmata (vor allem Verben und Adjektive) mit starken deontischen Dimensionen erkennbar macht. Die Wort- und Phrasenlisten wurden mit Hilfe maschineller Lernverfahren ermittelt.

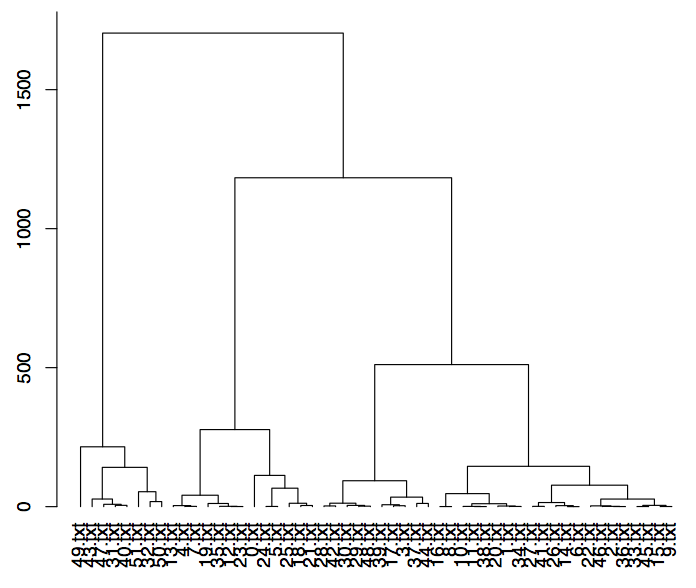

Betrachtet man die Entwicklung von SPON von 2000-2010 so fällt zunächst auf, dass die durchschnittliche Wortschatzkomplexität pro Artikel im Trend allmählich abgenommen hat:

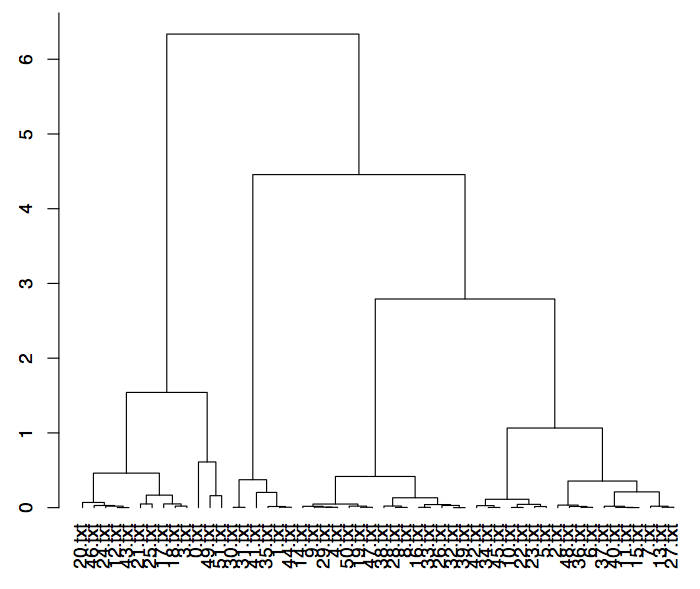

Dafür nehmen die Indikatoren für einen stärker mutmaßenden, d.h. weniger faktengesättigten, und skandalisierenderen journalistischen Stil nach und nach zu:

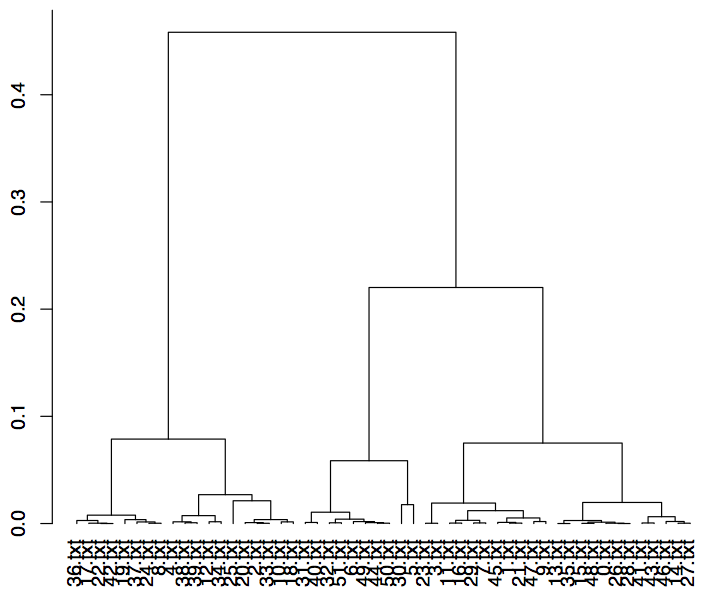

Der Manipulativitätsindex im Ressort Politik verharrt seit Mitte 2009 auf einem Niveau, den er zwischenzeitlich nur kurz nach den Terroranschlägen auf das World Trade Center hatte:

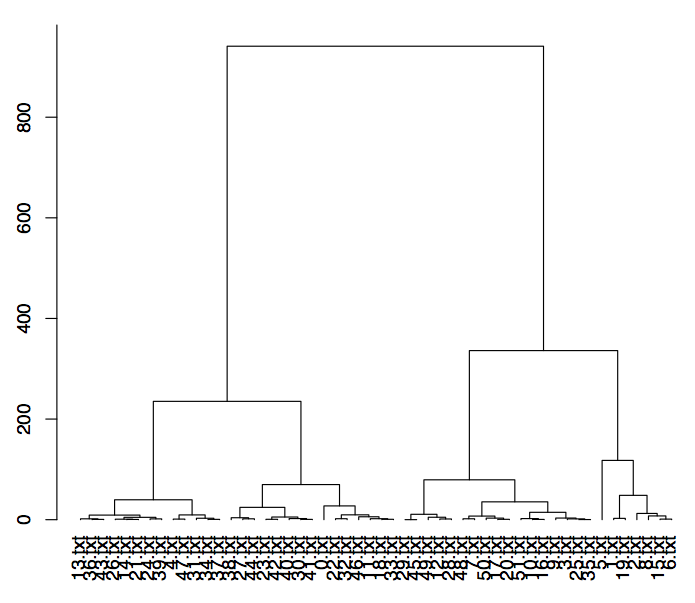

Interessant ist, dass der Angstindex im Ressort Wirtschaft den politischen Angstindex, der seit 9/11 auf erhöhtem Niveau verharrt, zweitweise im Zuge der Subprime-Krise überholt hat.

Diese Einsicht scheint zwar zunächst trivial, ist aber doch bemerkenswert, wenn man bedenkt, dass für den SPIEGEL die größte Gefahr nicht mehr von Terroristen, sondern von der Hochfinanz ausgeht.