Heute möchte ich eine Methode zur Klassifikation von Texten vorstellen, in der sprachliche Einheiten nicht isoliert betrachtet werden, sondern jeweils kleine Fetzen sprachlichen Materials analysiert werden. Je größer die analysierten Fetzen sind, desto eher kann man natürlich davon ausgehen, dass sie irgendwelche relevanten Informationen transportieren: Ein Satz enthält mehr Informationen als zwei Wörter. Je größer allerdings die Einheiten sind, desto unwahrscheinlicher ist es, dass sie in der gleichen Form wieder auftreten. Das ist wiederum problematisch, weil man bei der Analyse ja nach wiederkehrenden Mustern sucht und je größer die Einheiten sind, desto mehr Text braucht man, damit man wiederkehrende Muster in aussagekräftiger Zahl bekommt. Alles eine Frage der Skalierung also. Die im Folgenden beschriebene und erprobte Methode könnte man als komplexe n-Gramm-Analyse bezeichnen.

komplexe n-Gramme

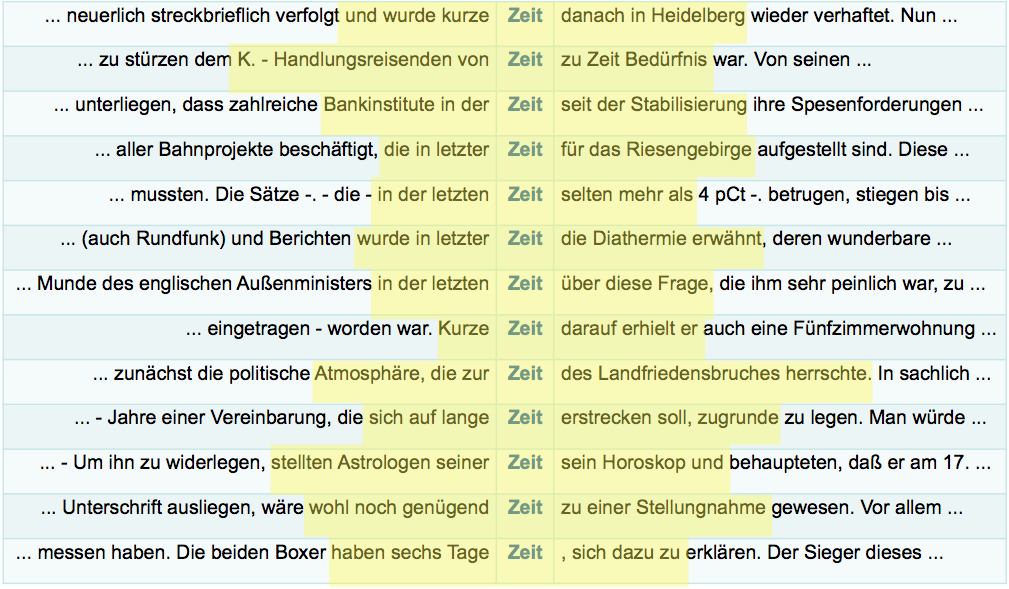

n-Gramme sind Einheiten, die aus n Elementen bestehen. Normalerweise werden n-Gramme als Folge von Wortformen verstanden. Im Rahmen einer n-Gramm-Analyse werden alle im Korpus vorkommenden n-Gramme berechnet, wobei bestimmte Parameter wie Länge der Mehrworteinheit (aus zwei, drei oder mehr Wörtern bestehend) oder Spannweite (sind Lücken zwischen den Wörtern erlaubt?) festgelegt werden. Die hier verwendete n-Gramm-Analyse betrachtet jedoch nicht nur Wortformen als Einheiten, sondern auch weitere interpretative linguistische Kategorien. Dies können zum einen Elemente sein, die sich auf die Tokenebene beziehen und die Wortform funktional oder semantisch deuten (als Repräsentant einer Wortart oder als Teil einer semantischen Klasse). Zum anderen aber auch Elemente, die über die Tokenebene hinausgreifen, etwa das Tempus oder die Modalität einer Äußerung (direkte vs. indirekte Rede).

Kombinationen von n Einheiten

Welche Elemente in die Analyse mit einbezogen werden, hängt einerseits von der jeweiligen Forschungsfrage ab, andererseits forschungspraktisch auch davon, welche Ressourcen für die Annotation des Korpus zur Verfügung stehen. Bei standardsprachlichen Korpora können Lemma- und Wortarteninformationen durch Tagger wie dem TreeTagger leicht und effizient annotiert werden. Eine Wortformenfolge wie „Ich glaube, dass“ hat dann in einem XML-annotierten Korpus etwa folgende Form:

<w pos=“PPER“ lemma=“ich“>Ich</w>

<w pos=“VVFIN“ lemma=“glauben“>glaube</w>

<w pos=“$,“ lemma=“,“>,</w>

<w pos=“KOUS“ lemma=“dass“>dass</w>

Berechnet man nun beispielsweise Tetragramme, die nicht nur die Wortformen, sondern auch Lemmata und Wortarteninformationen als weitere Elemente mit einzubeziehen, dann ergeben sich bei drei Dimensionen 3^4=81 Vier-Einheiten-Kombinationsmöglichkeiten:

Ich glaube , dass

ICH GLAUBEN , DASS

PPER glaube , dass

PPER GLAUBEN, dass

Ich VVFIN , dass

Ich glaube , KOUS

PPER VVFIN , dass

…

Jedes der Tetragramme, das sich in einem der beiden Korpora findet, kann nun als eine Variable aufgefasst werden, aufgrund deren Verteilung sich die Texte im Korpus potenziell stilistisch unterscheiden.

Das GerMov-Korpus

Die folgenden Untersuchungen werden anhand des GerMov-Korpus, einem Korpus zur gesprochenen und geschriebenen Sprache der 68er-Bewegung durchgeführt. Das Korpus habe ich im Rahmen einer umfangreichen Studie zum Einfluss von 68er-Bewegung und Alternativmilieu auf die Kommunikationsgeschichte der Bundesrepublik Deutschland erstellt. Bei der Zusammenstellung des Korpus und seiner Subkorpora waren zunächst außersprachliche Gesichtspunkte, in einem zweiten Schritt textlinguistische Überlegungen leitend. Das Korpus sollte es u. a. erlauben, unterschiedliche Stile der verbalen face-to-face-Interaktion innerhalb der 68er-Bewegung zu rekonstruieren. Dabei wurde ausgehend von der Forschung zum Kleidungsverhalten und zur medialen Vermittlung expressiver Formen des Protests von einer lebensstilistischen Dualität innerhalb der Bewegung ausgegangen, die ihre Wurzeln auch in konkurrierenden Ideologien hatte.

Sozialstilistik der 68er-Bewegung

Auf der einen Seite standen die Träger eines intellektuell-avantgardistischen Stils. Bei ihnen handelte es sich um Angehörige unterschiedlicher sozialer Gruppen, die während der 68er-Bewegung aber intensiv kooperierten: zum einen die Studierenden, vornehmlich solche, die in linken Studentenverbänden organisiert waren, zum anderen Linksintellektuelle, die in Politik, Universität, Verwaltung oder im kulturellen Sektor bereits Karriere gemacht hatten, die sich beispielsweise in Republikanischen Clubs zusammenfanden. Sie pflegten einen auf symbolische Distinktion zunächst weitgehend verzichtenden Lebensstil, trugen Anzug oder Freizeitkleidung (Hemd und Pullovern, Jacket und Cordhose) und praktizierten Lebensformen wie andere Menschen ihrer Berufsgruppen. Nur in einem Bereich legten sie Wert auf Unterscheidung: Sie inszenierten sich als intellektuelle Informations- und Diskussionselite.

Auf der anderen Seite standen die Träger eines hedonistischen Selbstverwirklichungsstils, der in Kommunen und Subkulturen geprägt wurde. Sie entdeckten den eigenen Körper als zentrales Medium des expressiven Protestes, griffen – ähnlich den amerikanischen Hippies – tief in den Fundus von Kostümverleihen und Second-Hand-Läden, spielten mit Nacktheit und Schmuck, ließen sich Bärte und Haare wachsen und praktizierten eine ostentativ informelle Körpersprache. Sie verschmolzen antibürgerliche symbolische Formen mit denen jugendlicher Populärkultur zu einem sich als individualistisch verstehenden, lustbetonten Lebensstil: Die Revolution sollte bei jedem Einzelnen beginnen und vor allem Spaß machen. Während die intellektuellen Avantgarden das Ziel der 68er-Bewegung in einer Umwälzung der Besitz- und Produktionsverhältnisse sahen, begriffen die hedonistischen Kommunarden also die Bewegung als Chance für die Entwicklung und Praktizierung neuer Lebensformen, die eine gesellschaftliche Veränderung zwangsläufig mit sich bringen würde.

Zusammensetzung des Korpus

Die Kriterien der Milieuzugehörigkeit der Textproduzenten, der Medialität / Textsorte und der Kommunikationssituation setzte der Textauswahl sehr enge Grenzen. Die einzige Textsorte, für die hinsichtlich aller Kriterien eine hinreichende Menge an Texten gefunden werden konnte, waren Tonbandprotokolle. Insgesamt konnten 29 Tonbandprotokolle aus den Jahren 1967 bis 1969 in Archiven und zeitgenössischen Buch- und Zeitschriftenpublikationen gefunden werden, davon stammen 21 aus dem hedonistischen Selbstverwirklichungsmilieu, 8 aus dem linksintellektuellen Milieu. Die Zuordnung erfolgte beim linksintellektuellen Milieu anhand der identifizierbaren Gesprächsteilnehmer und deren Zugehörigkeit zu politischen Gruppen, die jeweils den Milieus eindeutig zuzuordnen waren. Die Protokolle aus dem Kommunemilieu waren ausnahmslos als solche betitelt und wurden in szenetypischen Kontexten publiziert, was auch hier eine zweifelsfreie Zuordnung ermöglichte.

Das GerMov-Korpus wurde mit Hilfe des TreeTaggers tokenisiert, mit Wortarten-Informationen annotiert und lemmatisiert. Beim verwendeten Tagset handelt es sich um das Stuttgart-Tübingen-Tagset (STTS). Darüber hinaus wurden einige Kategorien auf der Token-Ebene wie Kommunikationsverben, Intensivierer und Schlagwörter der Neuen Linken annotiert.

Textclustering mittels komplexer n-Gramme

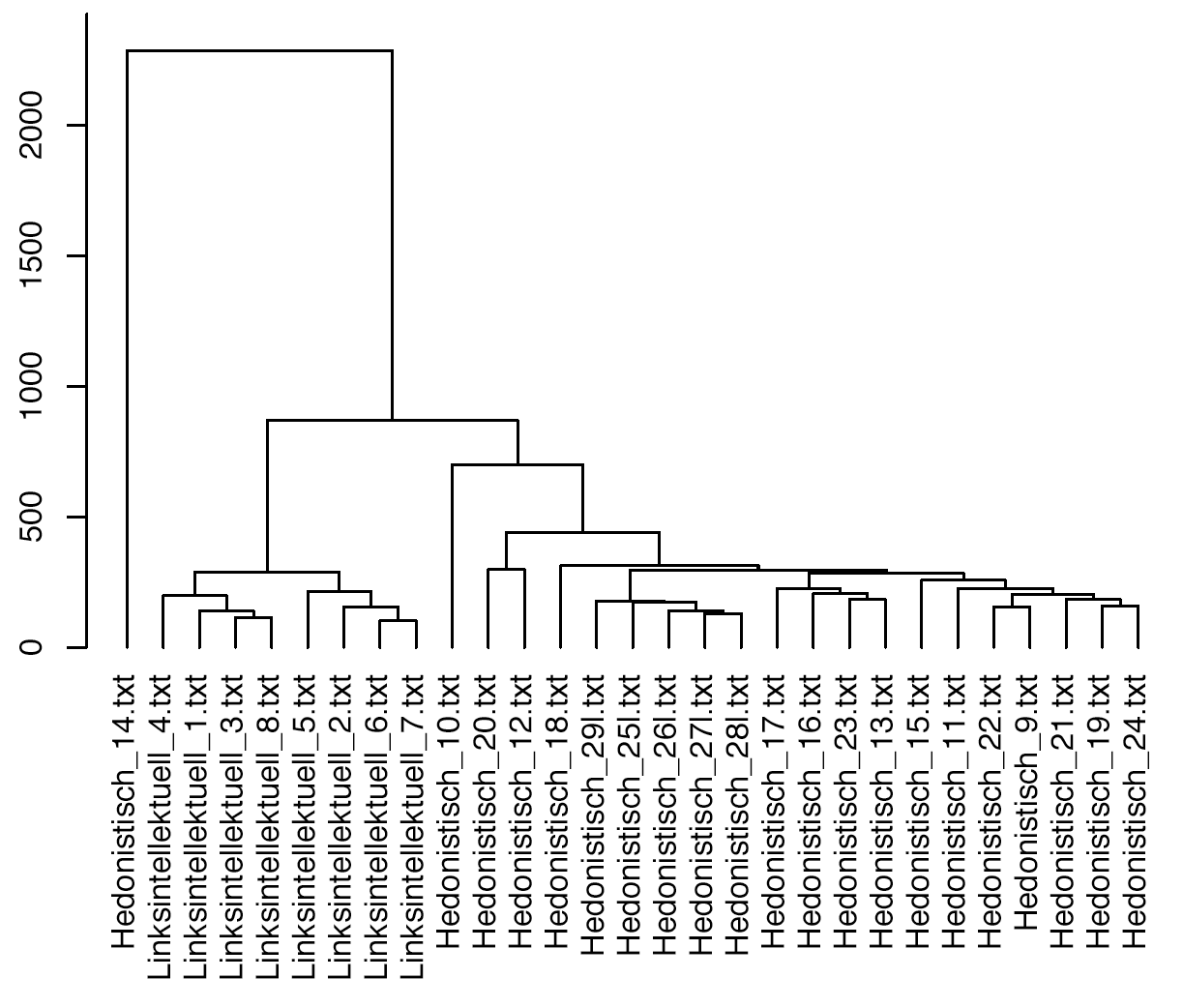

Berechnungsparameter: Berechnet wurden komplexe Pentagramme ohne Leerstellen, die aus den Dimensionen Wortarteninformation (einschließlich semantischer Klassen) und Wortformen zusammengesetzt wurden, wobei auf der Dimension Wortform nur Funktionswörter und Satzzeichen in die Analyse einbezogen wurden. Auf die Dimension Lemma wurde gänzlich verzichtet. Die Pentagramme wurden über Satzgrenzen hinaus berechnet. Es wurden nur solche n-Gramme in die Analyse aufgenommen, die im Gesamtkorpus mindestens vier Mal auftraten. Um den Einfluss der Textlängendifferenz zu reduzieren, wurden für die hierarchische Clusteranalyse nach dem Ward-Verfahren die Frequenzen der n-Gramme nach der Textlänge gewichtet.

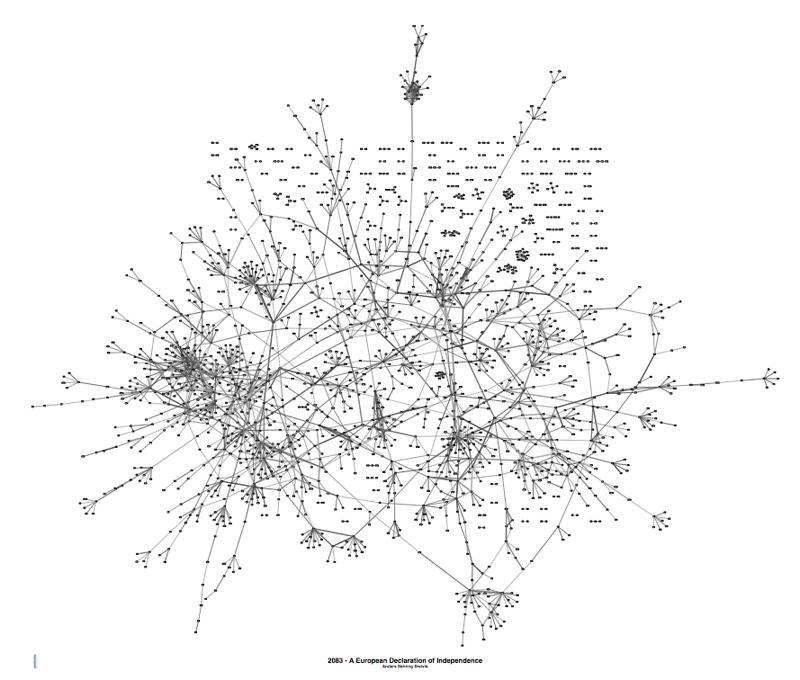

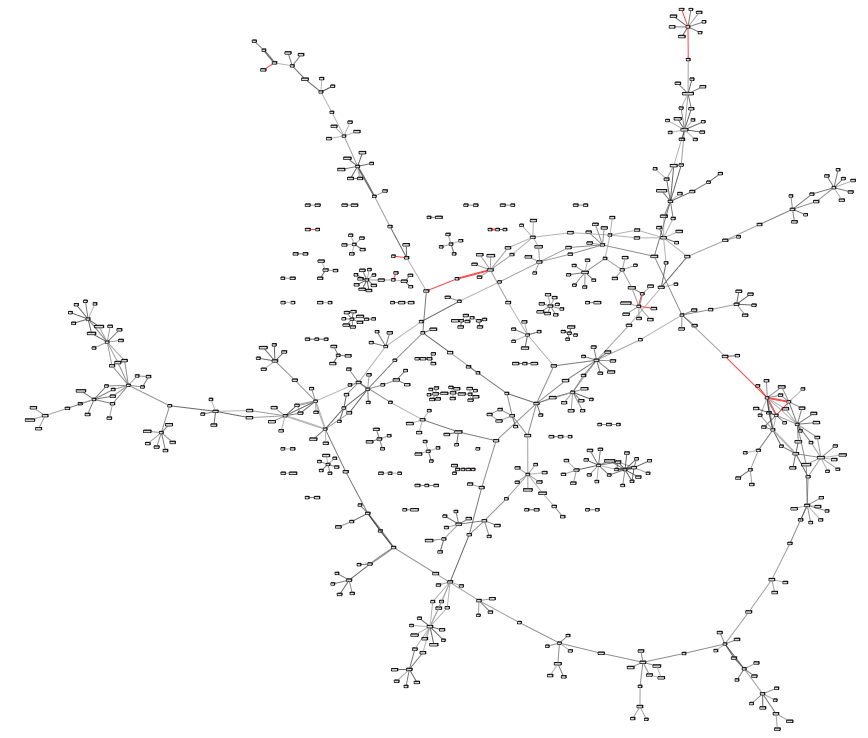

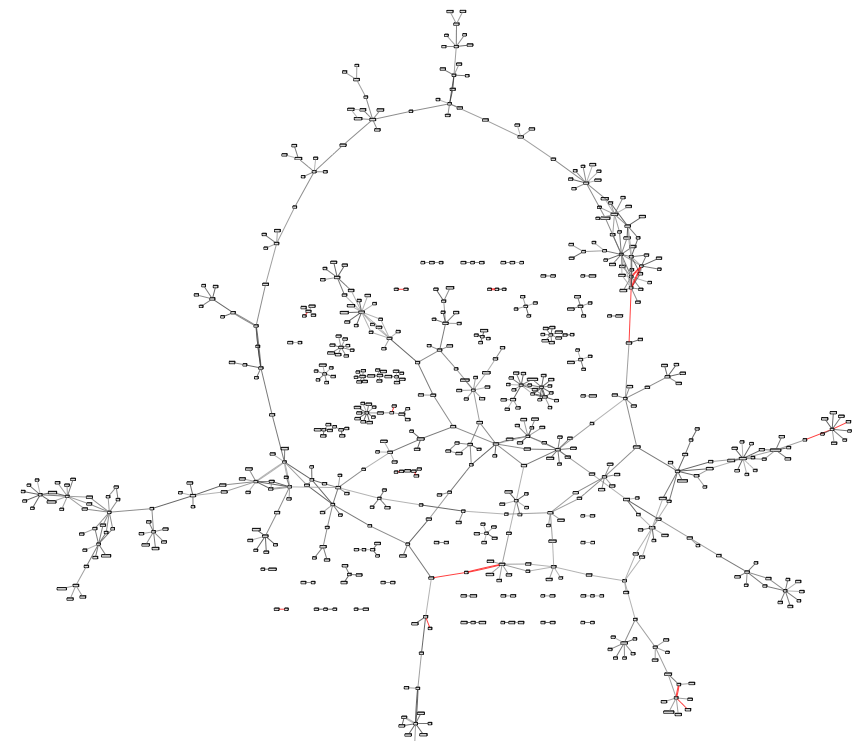

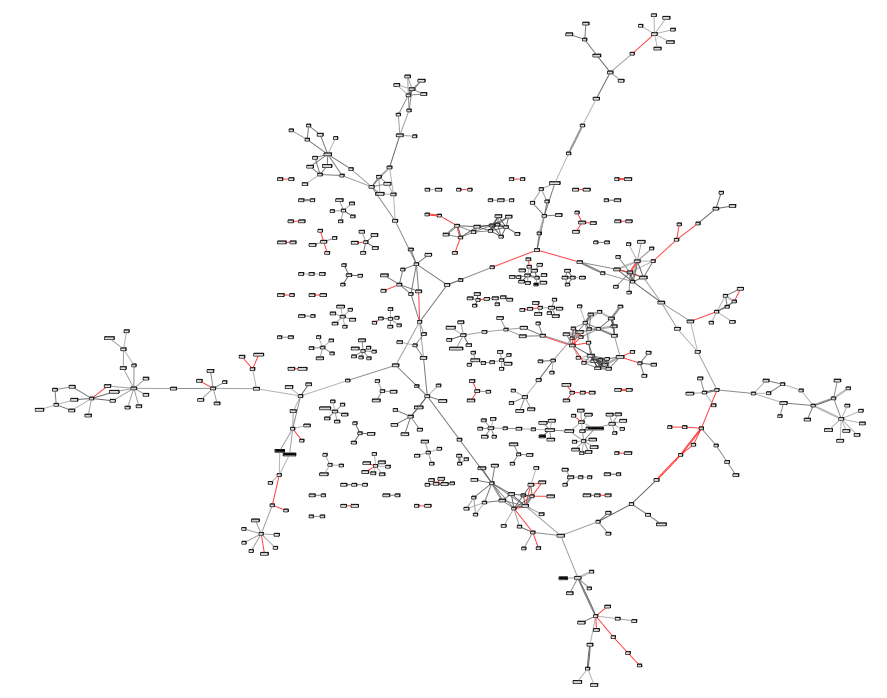

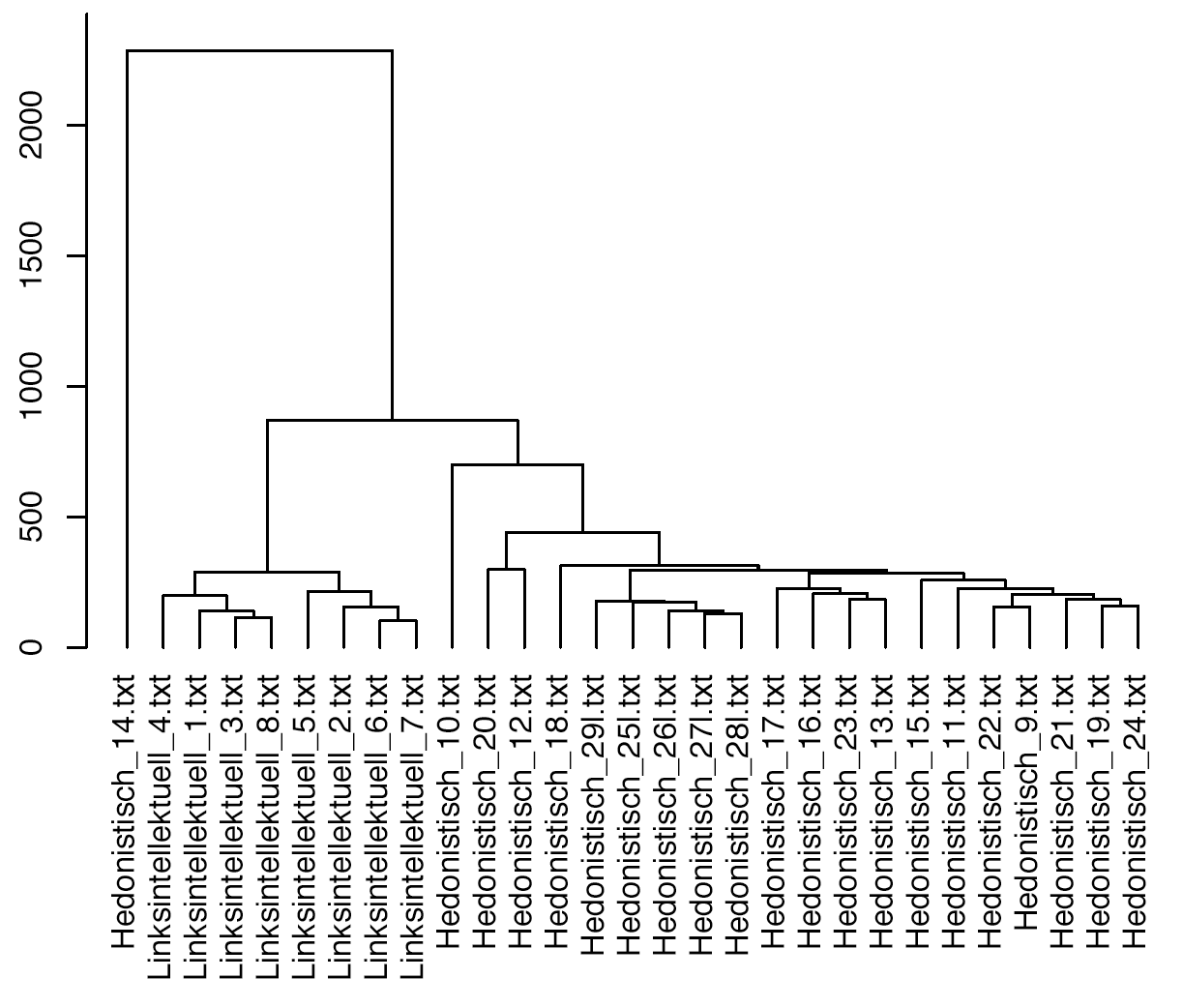

Nun aber zu den Ergebnissen der Clusteranalyse: Im folgenden Dendrogramm sind die Namen der Texte so gewählt, dass die anhand außersprachlicher Kriterien erfolgte Milieuzuteilung ersichtlich ist. „Linksintellektuell“ steht für das linksintellektuell-avantgardistische Milieu, „Hedonistisch“ für das hedonistische Selbstverwirklichungsmilieu. Die Ziffer im Anschluss an die Milieubezeichnung ist lediglich eine Identifizierungsnummer. Fünf der 21 Protokolle aus dem hedonistischen Selbstverwirklichungsmilieu stammen aus einer einzigen Kommue, der sog. Linkseckkommune. Sie wurden zusätzlich mit einem „l“ nach der ID gekennzeichnet.

Dendrogramm des Textclusterings anhand komplexer n-Gramme von Tonbandprotokollen der 68er-Bewegung

Die Clusteranalyse zeigt, dass die Protokolle aus dem linksintellektuellen Milieu ein Cluster bilden, das sich deutlich von den Protokollen des hedonistischen Selbstverwirklichungsmilieus unterscheidet. Innerhalb der Protokolle des hedonistischen Selbstverwirklichungsmilieus bilden die fünf Protokolle aus der Linkeckkommune wiederum ein eigenes Cluster. Die größte Differenz jedoch besteht zwischen Protokoll 14 aus dem hedonistischen Selbstverwirklichungsmilieu und allen anderen Protokollen. Wie ist dieser Unterschied zu erklären? Offensichtlich werden hier Effekte der Textlänge sichtbar. Das Protokoll Nummer 14 ist mit einer Länge von gerade einmal 71 Wörtern das kürzeste und enthält damit offenbar nicht hinreichend viel Text, um aus ihm eine für stilistische Analysen hinreichend große Menge an n-Grammen zu bilden. Die Gewichtung der Frequenz der auftretenden n-Gramme nach der Textlänge dürfte den Effekt noch verstärkt haben.

Geht man von der Annahme aus, dass den sozialstilistischen Unterschieden, auf deren Basis die Zuweisung der Texte zu Milieus erfolgte, auch kommunikationsstilistische Unterschiede korrespondieren, so deuten die Ergebnisse darauf hin, dass das gewählte Verfahren dazu ziemlich gut geeignet ist, stilistische Unterschiede aufzudecken.

Man muss aber der Ehrlichkeit halber hinzufügen, dass die stilistischen Unterschiede in den Texten wirklich sehr ausgeprägt sind und auch bei einer einigermaßen aufmerksamen Lektüre hätten auffallen müssen. Wirklich überrascht war ich allerdings davon, dass sich alle Protokolle der Linkeckkommune tatsächlich in einem Cluster wiederfanden.

Ausführlich nachlesen kann man das Ganze übrigens hier:

Scharloth, Joachim / Noah Bubenhofer (2011): Datengeleitete Korpuspragmatik: Korpusvergleich als Methode der Stilanalyse. In: Ekkehard Felder / Marcus Müller / Friedemann Vogel (Hrsg.): Korpuspragmatik. Thematische Korpora als Basis diskurslinguistischer Analysen von Texten und Gesprächen. Berlin, New York: de Gruyter.

Scharloth, Joachim / Noah Bubenhofer / Klaus Rothenhäusler (2011): „Anders schreiben“ aus korpuslinguistischer Perspektive: Datengeleitete Zugänge zum Stil. In: Britt Marie Schuster / Doris Tophinke: Anders schreiben. Berlin: Erich Schmidt Verlag.